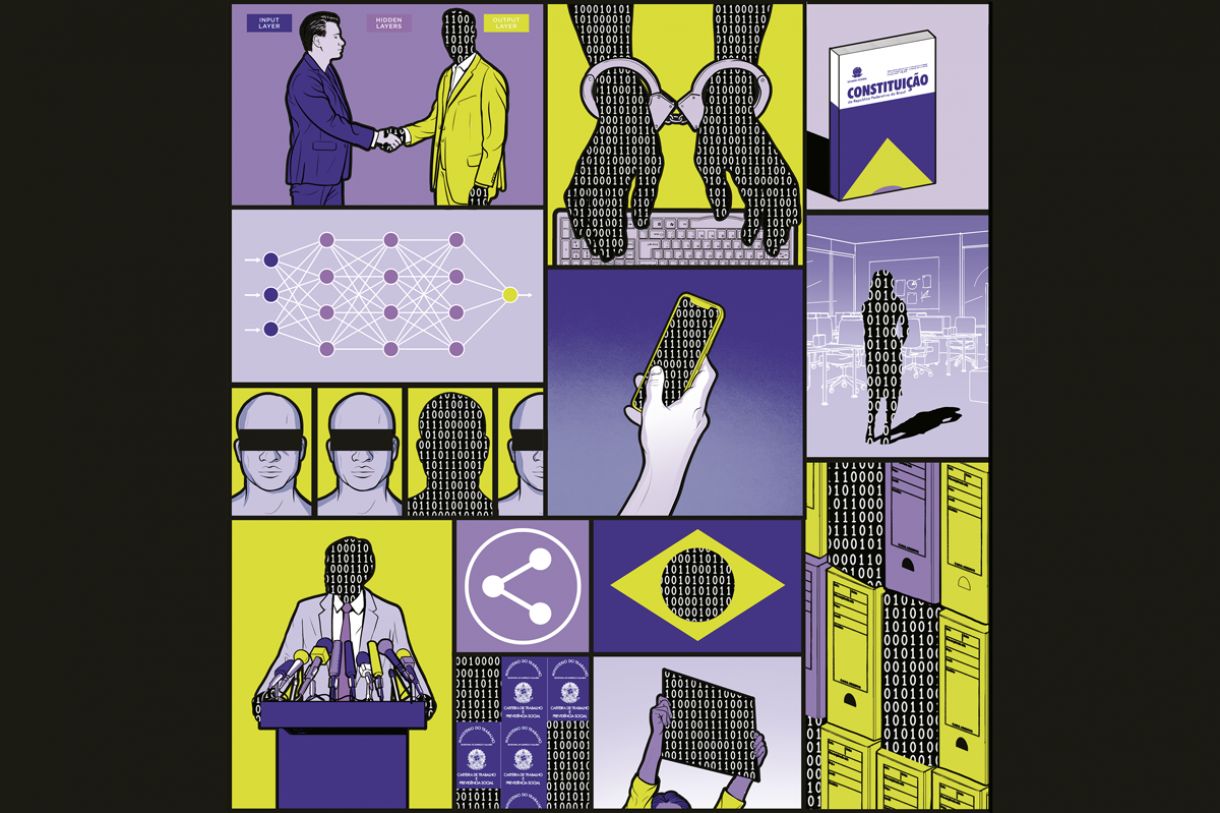

Inteligência Artificial: a era das máquinas pensantes

Avanços na área têm provocado reações que levam ao debate sobre sua regulação e seu futuro

TEXTO YELLOW

ILUSTRAÇÕES DAVI AUGUSTO

01 de Junho de 2023

Ilustração DAVI AUGUSTO

[aberto para degustação | ed. 270 | junho de 2023]

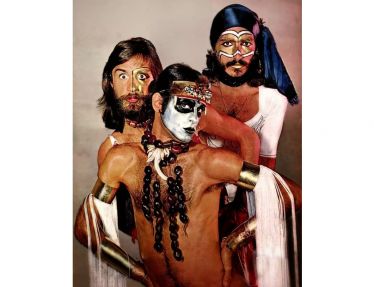

Os deuses devem estar loucos (1980) é um filme de comédia africano, que se tornou sucesso em todo o mundo. A premissa é espetacular: o cotidiano de uma tribo isolada do deserto Calaári é sacudido pelo surgimento de um objeto encantado – uma garrafa vazia de Coca-Cola, atirada da janela de um avião monomotor. Em pouco tempo, todos os indivíduos da tribo encontram utilidade para aquele presente vindo do céu. Graças a características inéditas para os nativos, a garrafa vira instrumento para produzir sons, cozinhar, acender fogo... Só que, em determinado momento, a disputa pelo uso da garrafa provoca tanta cizânia, que é decidido que o líder da tribo deve devolvê-la ao lugar de onde veio, e ele sai em uma jornada para devolver o presente aos seus criadores.

Este ano, uma atitude similar foi sugerida, em relação a um outra inovação, que está prestes a se tornar instrumento onipresente e indispensável a todos os habitantes da aldeia global. A Future of Life Institute, organização não governamental formada por cientistas, empresários e pessoas vinculadas instituições de governança, divulgou uma carta aberta na qual pede uma suspensão de seis meses nas pesquisas em Inteligência Artificial, para dar tempo à criação de legislação e mecanismos de transparência e responsabilização que tornem a tecnologia menos destrutiva para a sociedade.

O gatilho para esse pedido foi o lançamento do ChatGPT, um chatbot criado pela companhia norte-americana OpenAI. Lá em 1950, o matemático Alan Turing havia proposto que saberíamos que um computador pode pensar quando não pudéssemos distinguir se estávamos tendo uma conversa com uma máquina ou com um ser humano, e o ChatGPT parece passar no teste, para a maioria das pessoas.

A versão 3,5 do ChatGPT, lançada em 30 de novembro de 2022, recebeu (segundo a empresa que o fez) mais de um milhão de assinaturas nos primeiros cinco dias, tornando-o o produto digital de adesão mais rápida da história. Em pouco tempo, viralizaram histórias em todo o mundo de que estaria sendo usada por alunos para fazer tarefas de casa, que suas respostas eram suficientes para passar em provas escolares, e que poderia realizar tarefas de secretariado, direito e até medicina. Pessoas passaram a usar o chatbot até mesmo para fazer terapia.

Três meses e meio depois, a companhia divulgou o GPT-4, que tem um trilhão de parâmetros (variáveis em um sistema de IA cujos valores são reajustados durante o treinamento, para estabelecer como serão processadas as informações inseridas nele), comparados aos 175 milhões de seu antecessor.

A versão 4 consegue entender o contexto do que lhe é pedido com uma desenvoltura que não existia em seu antecessor. Também interpreta informações de diferentes linguagens, aceitando não apenas texto e imagens, mas praticamente qualquer coisa para a qual convencionamos um sistema de medidas.

O sucesso do GPT-4 provocou uma corrida do ouro entre as grandes empresas de tecnologia do mundo. Em poucos dias, a Microsoft avisou que detinha direitos de uso das ferramentas da OpenAI desde 2020, e iria incorporar a IA ao pacote Office e ao Bing, sistema de busca que, de uma piada, promete se tornar finalmente um concorrente à altura do Google.

Por falar na empresa, em 10 de maio, na abertura da conferência anual de desenvolvedores, Google I/O, o termo Inteligência Artificial foi citado nada menos que 143 vezes. Prometeram a integração da tecnologia a suas ferramentas, com funcionalidades para escrever e-mails (entendendo o contexto através do histórico de mensagens), criar tabelas e apresentações, cruzar dados pessoais com busca, editar imagens (como incluir ou excluir pessoas e objetos, diretamente no Google Photos) e vídeos, auxiliar médicos em diagnósticos e programadores a escreverem códigos. As ações da empresa aumentaram de valor em 56 bilhões de dólares, em um dia.

E, em um anúncio bem menos auspicioso, a IBM também aproveitou o hype para, no dia 1º de maio, talvez em uma homenagem sarcástica ao Dia do Trabalhador, anunciar que passará a suspender todas as contratações para cargos cujo trabalho possa ser realizado por IA. Esperam eliminar 7.800 posições em cargos, supostamente, administrativos.

Mas de onde vieram as IAs, que parecem ter surgido do nada e agora ameaçam nossos empregos e o futuro da humanidade?

ORIGEM E FUNCIONAMENTO

“Diferentemente do que muita gente pensa, a Inteligência Artificial não é uma coisa nova”, afirma o professor da UPE Carmelo Bastos, vice-presidente da Sociedade Brasileira de Inteligência Computacional. “Existem estudos que datam da década de 40 do século passado, que já mostram a intenção de mimetizar a inteligência humana a partir de redes neurais artificiais, imitando os neurônios biológicos e sua ação, e o desenvolvimento se deu ao longo de todos esses anos em diversas fases, inclusive em fases em que a IA foi desacreditada.”

No verão de 1956, um punhado de matemáticos e cientistas da computação se reuniu no Dartmouth College, no norte dos Estados Unidos, por cerca de oito semanas, para discutir as possibilidades de um novo campo de pesquisa. Coube ao professor John McCarthy a criação do termo Inteligência Artificial, no convite para o evento, explicando que este se destinaria a explorar a hipótese de que “todos os aspectos do aprendizado ou qualquer outra característica de inteligência podem, em princípio, serem descritas de forma tão precisa que uma máquina pode ser feita para simulá-la”.

Este encontro estabeleceu os fundamentos da IA, chegando a prever, teoricamente, muitos problemas que os sistemas desse tipo lutam para minimizar até os dias de hoje. Já a partir das discussões em Dartmouth, ficou claro que existiam duas abordagens para o problema: a “simbólica” e a “conectiva”.

Os pesquisadores dedicados à IA Simbólica acreditavam na criação de modelos algoritmos baseados em teorias sobre o funcionamento da mente humana. Até hoje, não existem definições absolutas de conceitos como “mente” ou “consciência”. Mas isso não nos impede de conjecturar possibilidades para o funcionamento dessas entidades, e escrever conjuntos de regras que simulem esse funcionamento.

Destacou-se nesse campo o cientista cognitivo Marvin Minsky, que, após um início de carreira explorando a IA conectiva, dedicou o resto de sua vida a investigar modelos simbólicos para explicar o funcionamento da inteligência. São dele os livros A sociedade da mente (1986) e The emotion machine (2006).

O lendário professor Richard Feynman explicou e justificou a IA simbólica em uma fala gravada em 1985, que hoje pode ser encontrada no Youtube. Perguntado se máquinas poderiam pensar como os humanos, sua resposta foi de que poderiam, mas não como nós: “Se quisermos fazer algo que corra rapidamente sobre o solo, podemos observar um guepardo correndo e tentar fazer uma máquina que corra como um guepardo. Mas é mais fácil fazer uma máquina com rodas. Com rodas rápidas, ou algo que voe logo acima do solo, no ar. (...) Os aviões não voam como um pássaro. (...) Eles não batem as asas. Têm na frente uma coisa que gira, ou o avião mais moderno tem um tubo onde você aquece o ar e esguicha por trás, um propulsor a jato. (...) É diferente, certo? Portanto, não há dúvida de que as máquinas posteriores não vão pensar como as pessoas pensam”.

Os seres humanos entendem a linguagem (e todos os estímulos sensoriais) através de representações mentais – modelos – que correspondem ao nosso conhecimento do mundo e expectativas acerca de situações. Podemos construir algoritmos com conjuntos de regras para atuar no mundo da maneira que uma pessoa inteligente agiria. Para dar um exemplo muito simples: uma calculadora de bolso não “sabe matemática”. Mas, através de instruções simples, ela consegue dar ao usuário resultados perfeitos de operações aritméticas, sendo “mais inteligente” em tabuada do que muita gente.

“Com relação à inteligência, acho que é exatamente da mesma forma”, continua Feynman. “Máquinas não fazem aritmética da mesma forma que nós fazemos, mas fazem melhor. (...) Nunca vamos mudar a forma como as máquinas fazem aritmética, para torná-la mais parecida com os humanos. Isso seria andar para trás, porque a aritmética feita pelos humanos é lenta, pesada, confusa e cheia de erros. E as máquinas são rápidas.”

A IA simbólica trouxe ao mundo grandes avanços, principalmente na forma de automação, em áreas específicas, muito especializadas, o que se convencionou chamar de IA estreita. Confirmando a máxima de Larry Tesler, pioneiro da computação, “IA é o que ainda não foi feito”. A IA estreita está por todos os lugares, hoje em dia. O termostato dos aparelhos de ar-condicionado, o corretor automático do Word, o crédito pré-aprovado no seu banco, as recomendações de títulos nos serviços de streaming, ou de matchs pra o seu date, o comportamento dos personagens nos quais atiramos, em videogames, o autofoco das câmeras dos smartphones, que reconhecem e focam em vários rostos em uma mesma foto… É tudo IA.

Mas a comprovada eficácia de sistemas simbólicos em tarefas especializadas não impediu que alguns de seus proponentes sugerissem que uma IA simbólica, com uma estrutura suficientemente grande de fatos e premissas, pudesse dar luz a uma inteligência ampla, popularmente conhecida como “senso comum”. Nunca chegamos nem perto com a IA simbólica.

Resultados práticos contribuíram para que pesquisas em IA simbólica continuassem a encontrar financiamento, até meados dos anos 1980. Quando aconteceu a popularização dos computadores pessoais, a pesquisa em computação passou a focar em problemas mais evidentes e lucrativos, como o desenvolvimento das interfaces gráficas, o que tornou os computadores mais fáceis de serem usados. E a IA ficou fora de moda.

A IA conectiva segue outra lógica. A teoria é de que, se conseguirmos criar um sistema que funcione como o cérebro humano, e inundarmos este “cérebro eletrônico” de estímulos, ele vai aprender a pensar sozinho. As Redes Neurais Artificiais (RNAs) são formadas por grandes conjuntos de unidades de processamento interconectadas, chamadas neurônios, porque simulam o funcionamento de nossas células nervosas. Uma RNA funciona através de treinamento, que pode ou não ser supervisionado. No treinamento supervisionado, inserimos dados (por exemplo, fotos) com rótulos (por exemplo, “maçã” ou “banana”), e várias camadas de RNA processam o relacionamento entre imagem e rótulo, inferindo regras (parece que maçãs tendem a ser vermelhas e redondas, e bananas, amarelas e compridas). Ao final do treinamento, idealmente, a RNA vai criar um modelo (um algoritmo que consegue distinguir se, em uma foto, há uma maçã ou uma banana).

Décadas se passaram até que o mundo desenvolvesse tecnologias capazes de reproduzir sequer frações do poder de processamento necessário para realizar essa tarefa. Teoricamente, as Redes Neurais Artificiais já existiam desde antes da criação do termo Inteligência Artificial. Mas havia barreiras práticas para sua efetivação.

O problema principal das RNAs, durante cerca de 40 anos, foi seu alto custo computacional. Pioneiros em sua utilização, Frank Rosenblatt e nosso amigo Marvin Minsky construíram as primeiras máquinas a utilizarem o processo para fazê-las “aprenderem” ainda na década de 1950. Mas eram traquitanas caríssimas, montadas apenas como prova de conceito e financiadas pelo Departamento de Defesa Americano (que, graças à paranoia da Guerra Fria, também bancou o desenvolvimento da internet e do mouse, entre outras coisas). A máquina de Rosenblatt contava com 1.000 neurônios, apenas, enquanto um cérebro humano é formado por 86 bilhões de Ticos e Tecos.

A já citada popularização dos PCs trouxe consigo uma diminuição no valor dos chips (observada por Gordon Moore, cofundador da Intel, morto em março de 2023, que previu que esse número cairia pela metade a cada dois anos), viabilizando a construção de Redes Neurais cada vez maiores.

Um empurrão enorme veio do desenvolvimento de placas aceleradoras de vídeo, dedicadas aos jogos, de imagens cada vez mais realistas, compostas em tempo real. Empresas como NVIDIA e AMD, que cresceram graças à demanda pelo produto, hoje são responsáveis pelo hardware em que rodam as RNAs. Obrigado, nerds!

Mas ainda havia mais um problema para a efetiva utilização de RNAs. Embora existissem os padrões teóricos e o crescente poder computacional, no início dos anos 1990, o mundo ainda era majoritariamente analógico, e não haviam dados digitais suficientes para treinar esses sistemas. Nas décadas seguintes, a popularização da web, da fibra óptica, tecnologias de armazenamento de dados, câmeras digitais, smartphones e redes sociais se encarregaram de gerar o turbilhão de dados que faltava à equação.

“Houve um desenvolvimento tecnológico fantástico nos últimos 70, 80 anos, nas indústrias de eletrônica, na indústria de fotônica, na indústria de telecomunicações, que permitiu que hoje a gente pudesse fazer aquisição, transmissão, processamento, armazenamento de dados em nuvem, e hoje a gente consegue ter uma massa de dados gigantesca”, subscreve Carmelo Bastos. “Com isso, e a popularização dos computadores, o que aconteceu foi que as pessoas começaram a ter acesso à utilização dessas ferramentas, e isso acelerou o seu desenvolvimento.”

A aplicação de RNAs de várias camadas fez surgir o que se convencionou chamar de deep learning. A partir da entrada de uma quantidade muito grande de dados, uma RNA é capaz de identificar padrões e associar eventos, fazendo surgir regras emergentes. Isso faz com que as RNAs sejam capazes de inferir até mesmo padrões que não são percebidos pelos humanos. Se forem satisfatórios para a realização da tarefa em questão, os conjuntos de regras inferidas por uma RNA podem ser consolidados em um modelo.

É um equívoco comum achar que uma IA dispõe de um cérebro eletrônico, aprendendo e se modificando o tempo todo. Pode vir a ser o caso, no futuro. Mas, por enquanto, os computadores capazes de realizar Redes Neurais são enormes, compostos de bilhões de transistores, e gastam muita energia. Estes criam modelos, programas menores e replicáveis, que são usados em nuvem ou até diretamente em dispositivos menores, como PCs, smartphones ou consoles de videogame.

As RNAs possibilitaram a criação de veículos autônomos, assistentes virtuais acionados por voz, tradução instantânea entre diversas línguas, e ainda aprenderam a nos vencer em diversos jogos, como Xadrez e Go. As IAs de hoje já influenciam todas as indústrias, reconhecendo padrões e nos ajudando a tomar decisões complexas. Mas elas apresentam problemas de difícil tratamento, que perduram e nos impedem de confiar nos modelos estritamente conectivos para tomar decisões realmente importantes.

CHEGADA DOS TRANSFORMADORES

A década de 2010 marcou um período em que os investimentos no aumento de RNAs não estavam apresentando retorno proporcional em resultados ou em aplicações comerciais. Marvin Minsky, por exemplo, morreu em 2006, reclamando que a IA estava estagnada. Porém, os últimos anos viram o surgimento de novas arquiteturas.

Durante todo o seu desenvolvimento, as RNAs eram dedicadas a problemas específicos, como reconhecimento de imagens, reconhecimento facial, robótica, processamento de fala, e os avanços em cada uma dessas áreas ficavam restritos. A partir de 2017, foi inventada uma nova classe de IAs, chamadas Transformers.

Através de um código muito simples – pode ser escrito em 200 linhas –, tornou-se possível tratar absolutamente qualquer coisa como “linguagem”. Então, antes, você poderia treinar um modelo com texto e fazê-lo responder na forma de texto. Mas agora, um mesmo tipo de IA consegue interpretar e cruzar diferentes modos de dados, como texto, vídeo, áudio, ressonância magnética, DNA, dados biométricos, linguagens de programação, música, mercado de ações…

Isso significa, também, que avanços em qualquer campo do conhecimento se refletem em outros, e, por isso, estamos presenciando uma grande explosão no número e na qualidade de aplicações para a IA.

PROBLEMAS DAS IAS

Nada disso implica na resolução imediata de problemas que afetam as IAs desde suas origens. Às vezes as IAs erram. Outras vezes, elas simplesmente entendem tudo errado. E, pra completar, às vezes elas também esquecem as coisas. Elas podem errar por vários motivos. O principal deles é que, por definição, um modelo é um compressor de informação. Ainda mais, é um sistema que perde informação no processo.

“As máquinas (as de machine learning…) ‘aprendem’ usando um processo de extração de características, equivalente a forçar a informação do universo de interesse (presente nos dados de treinamento, no caso do ChatGPT, parte da web) por um gargalo que comprime os dados (e o ruído que os acompanha) o máximo possível, preservando – até o limite definido no treinamento – a informação representada nos dados… usando um espaço muito menor do que a web”, explica Silvio Meira, cientista-chefe da empresa de consultoria TDS, professor extraordinário da Cesar School e presidente do conselho do Porto Digital, em seu blog.

Um exemplo de compressão: se você tirar uma selfie com o seu celular e depois fizer upload desse arquivo em um site, para usar como foto de perfil, pode notar que a imagem vai ter menos detalhes do que a original. De repente, a cor do seu olho pode estar um pouco diferente, ou não vai dar para ler o que está escrito na camisa. Isso acontece porque o seu arquivo foi comprimido, para não ocupar muito espaço no servidor do site.

Não podemos representar em poucas regras um mundaréu de informações, simplificações serão cometidas. É por isso que sistemas de geração de imagens, como Midjourney e DALL-E, são tão ruins em desenhar mãos e dedos. Eles não “entendem” que é uma parte do corpo humano, composta por ossos, cartilagem e músculos, que é o modelo que está rodando no cérebro de um desenhista humano. Preenchem pixels por estatística (“Qual seria o valor mais provável para este pixel, se ele está rodeado por esses outros valores?”), criando aberrações que deixariam Picasso orgulhoso.

Mas IAs não apenas erram (pois humanas), como também, parafraseando nossas avós, aprendem muito do que não presta. Quando aprendem errado, para começar, pode ser pela própria lógica do algoritmo programado por um humano, no caso das IAs simbólicas. O programador pode ser um reacionário, e escrever lá que não existe gênero, só sexo, que pode ser masculino ou feminino. Ou que menino veste azul e menina veste rosa. E o pobre do algoritmo vai reproduzir infinitamente essa triste representação do mundo em todos os dados que processar. Isso, as nossas avós resolviam com cascudo. Toca no ponto da responsabilização, considerada um dos princípios para o desenvolvimento e uso de IAs.

O que é considerado o primeiro exemplo de viés racista em IA se deu exatamente assim. Em 1979, o Dr. Geoffrey Franglen criou um sistema para avaliação de currículos de novos alunos para a St. George’s Hospital Medical School, em Londres. Em 1986, após suspeitas e denúncias, foi descoberto que o algoritmo pontuava mais alto alunos do sexo masculino, com nomes e sobrenomes considerados caucasianos e europeus.

Nesse caso, a faculdade acabou sendo considerada culpada, após uma investigação da Comissão por Igualdade Racial do Reino Unido. Mas escapou sem grandes consequências: tentou entrar em contato com pessoas que sofreram discriminação algorítmica (estima-se que foram 60 por ano), e apenas a três foram oferecidas vagas na escola.

“As IAs são máquinas, ou objetos técnicos, cujo desenvolvimento é realizado a partir de referenciais, imaginários, acervos, e informações em geral preconceituosas”, atesta Lula Pinto, jornalista e sociólogo, professor da Escola de Comunicação da Unicap. “Isso acontece porque as equipes que desenvolvem essas tecnologias não contam com a diversidade necessária, nem são guiadas por políticas, procedimentos e protocolos que evitem ou combatam comportamentos preconceituosos.”

Mas, quando uma RNA aprende sozinha, através de um conjunto de dados, também pode criar modelos com vieses (tendências) preconceituosos, racistas, homofóbicos… Depende dos dados que usamos para treinar a IA. E o que não falta a uma sociedade preconceituosa são dados que refletem sua índole.

As redes neurais precisam ser alimentadas com uma quantidade enorme de dados digitais, para inferir padrões. Mas dados não são a realidade, senão representações. Se usarmos, por exemplo, todas as imagens postadas no Instagram para ensinar uma IA sobre biótipos e bem-estar, ela certamente vai aprender que o indivíduo médio é bem mais magro e sorridente que a realidade.

Para dar um outro exemplo trivial, vamos supor que queiramos aprender alguma coisa sobre o mundo, usando dados de todos os smartphones. Apenas isso já é o suficiente para excluir muita gente da equação. Por mais ubíquos que possam parecer, apenas 66% dos humanos os possuem. A amostragem, então, mostrará um mundo mais branco e mais rico do que ele realmente é.

“Isso é bem sério, pois impacta a vida das pessoas, por questões de representatividade, importância de grupos sociais, dentre outras situações”, atesta Anthony Lins, doutor em Biotecnologia, professor e pesquisador da Pós-graduação em Indústrias Criativas da Unicap, que atua com IA aplicada a pesquisas em diferentes contextos. “A partir do momento em que se busca por informações ou imagens sobre pessoas numa determinada condição negativa, nos resultados apresentados, estão majoritariamente representados por pessoas não brancas. Em outra pesquisa, com um contexto positivo, temos resultados com pouca ou nenhuma representatividade de pessoas não brancas. Isso acontece devido ao processo de ‘ensinar’ a IA sobre esses contextos, indicando o viés do que pessoas não brancas representam. Uma das reflexões que podemos fazer aqui é, a quem interessa esse tipo de enviesamento?”

“É necessário o estabelecimento de marcos regulatórios para o uso das IAs”, continua Pinto. “Todas as empresas que passaram a desenvolver e disponibilizaram seu uso o fizeram se aproveitando da falta de regulação – um modus operandi que se padronizou entre as Big Techs para outros produtos, em anos anteriores. E, seguindo o padrão da branquitude, consideram que pedidos de desculpas são suficientes para sanar os estragos causados pela abertura da caixa de Pandora.”

Por fim, um dos empecilhos das RNAs é que os modelos por ela gerados têm pouca ou nenhuma capacidade de adaptação. É bem difícil incrementar um modelo gerado através de RNAs, simplesmente através de um upgrade no processamento neural. Mesmo com dados de entrada idênticos, e chegando a modelos bem parecidos, a informação passa por caminhos probabilísticos completamente diferentes a cada camada. É o fenômeno do esquecimento catastrófico. Não bastasse a enorme quantidade de processamento necessária para o treinamento de um modelo através de RNAs, seu resultado não é cumulativo. Para evoluir um pouco, é preciso começar o treinamento todo do zero. E por essas e outras é que uma IA é, ainda, uma tecnologia tão cara.

PERIGOS

Muito se discute sobre o impacto que as IAs terão, em breve, no mercado de trabalho. Tecnologias disruptivas destroem indústrias inteiras, mudando completamente o mercado de trabalho. Basta lembrar que, antes da virada do século, havia pelo menos uma dezena de lojas de revelação de fotografias, apenas na Avenida Conde da Boa Vista, Centro do Recire, e tudo virou pó com a chegada das câmeras digitais.

Em uma pesquisa publicada no relatório Future of Jobs 2023, produzido pelo World Economic Forum, foi questionado a várias empresas se elas esperam criar ou eliminar mais empregos, com a adoção de diversas tecnologias. A Inteligência Artificial, por enquanto, mantém um balanço 25% positivo entre empregos que desaparecerão e empregos que serão criados.

“Como é quase sempre o caso em inovação de todos os tipos, haverá destruição e criação de trabalho, e não necessariamente quem teve seu trabalho destruído no processo conseguirá se colocar como candidato ao trabalho que será criado,” escreve Silvio Meira em seu blog. “Exatamente porque agora existe uma gama de sistemas que ‘conversa’ (e ‘pinta’ quadros… etc.) (...) os negócios que quiserem se diferenciar precisam de mais pessoas com habilidades ainda mais fortes de escrita e comunicação, e não menos gente com tais capacidades. Até porque conduzir um diálogo significativo com um ChatGPT não é uma tarefa fácil pra qualquer um… exige uma habilidade que não se ensina na escola, quase não se aprende no trabalho, quase sempre se trata com desprezo na sociedade, que é exatamente a de… fazer perguntas.”

Por enquanto, haverá a boa e velha disrupção – do mesmo tipo que precarizou o trabalho dos motoristas, que antes dirigiam táxis e agora são Ubers. Mas tudo indica que, em determinado momento, sistemas robóticos e de IA poderão, realmente, deixar obsoletos os humanos. Até mesmo Elon Musk, que não é necessariamente conhecido por sua inclinação socialista, admite que a Renda Básica Universal é algo cuja implantação será necessária em breve, graças ao desemprego que as IAs provocarão em todo o mundo.

Mas os medos relativos à IA vão muito além do remanejamento no mercado de trabalho. Na palestra The AI dilemma, disponível no Youtube, Tristan Harris e Aza Raskin explicam que as Redes Sociais foram apenas o primeiro contato da humanidade com a IA, através dos sistemas de recomendação.

“Mas essa tecnologia comparativamente simples foi o suficiente, em um primeiro contato com as IAs, para quebrar a humanidade, com problemas como o sobrecarregamento de informações, vício, cultura influencer, sexualização de crianças, Qanon, diminuição da capacidade de concentração, polarização política, bots, deep fakes, fake news e o colapso da democracia. E não era intenção de ninguém que essas coisas acontecessem. Apenas tínhamos engenheiros tentando maximizar o engajamento”, explicam os mesmos autores do documentário O dilema das redes, lançado em 2020 na Netflix. “O monstro do engajamento tomou conta da sociedade e está mantendo como reféns política, mídia e jornalismo, identidade das crianças, segurança nacional, valores, PIBs. Todas essas coisas acontecem em e são dependentes de mídias sociais”, continuam.

Com a capacidade das IAs Transformadoras de cruzar informações e entender o contexto, eles acreditam que estamos prestes a ver o colapso da realidade, pois tudo será deep fakes. Haverá colapso na confiança entre as pessoas, nas leis, e um aumento insustentável nos cibercrimes, graças à automação de hacks e exploração de vulnerabilidades em sistemas de informação. Além disso, utilizando-se do potencial das Redes Sociais, as IAs ainda facilitarão a manipulação política e a persuasão de pessoas.

Mas isso não é tudo. Existe o perigo de aprendizados emergentes, que sequer estão sendo detectados pelos pesquisadores. Nos últimos dois anos, por exemplo, as IAs estão desenvolvendo aceleradamente a capacidade de discutir o que se chama Teoria da Mente. É um tipo de pensamento que depende de entender e empatizar com os sentimentos do interlocutor, e é um marcador da maturidade psicológica das pessoas.

E, por fim, acredita-se que em breve as IAs poderão treinar a si mesmas, criando dados de treinamento, se necessário. Os perigos de abrigar no nosso planeta entidades superinteligentes (e meio racistas) que não compartilham limitações com os seres humanos, como a presença corporal ou a morte, já foram amplamente discutidos por Ray Kurzweil em seus livros sobre a Singularidade.

Mas alguns são mais céticos quanto à possibilidade de IAs com “consciência”, porque os seres humanos são muito mais que apenas cérebros. “O cérebro é uma rede, gigantesca, altamente conectada, distribuída por todo o corpo, instrumentada por uma grande rede de sensores e atuadores, processamento de sinais em ultra larga escala, sobre uma plataforma de carbono, cujo código é DNA”, disse Silvio Meira à Continente. “Nada impede que processadores sobre silício, em grande número, em rede, altamente conectados, instrumentados por uma grande rede de sensores e atuadores, faça a mesma coisa que um corpo humano. Mas nós não vivemos em uma época mais especial do que outra qualquer. Algo me diz que vai acontecer. Mas nós não vamos ver.”

Para Max Tegmark, professor do MIT e presidente do Future of Life Institute, a carta aberta que pedia pela pausa de seis meses na pesquisa de IA já atingiu seu modesto objetivo: “Pessoalmente, eu esperava que essa carta ajudasse a trazer a público a discussão de se precisamos, pela primeira vez, desacelerar as pesquisas mais arriscadas”.

“Espero que isso faça com que muitos formuladores de políticas percebam que isso não é ficção científica”, continuou Tegmark, em entrevista à Deutsche Welle News. “A inteligência não é algo misterioso que só pode existir no cérebro humano, é algo que também podemos construir. E, quando podemos construí-lo, também podemos construir coisas que estão diretamente além de nós, tão além de nós quanto estamos além dos insetos. E, obviamente, estamos construindo isso! Devemos construir IA pela humanidade e para a humanidade, e não para que as máquinas se divirtam mais tarde. Então, ter certeza de que realmente nos damos tempo para ter certeza de que controlamos essas coisas, de garantir que elas tenham nossos valores e façam o que queremos, isso é algo mais importante do que qualquer outra escolha que a humanidade está fazendo agora.”

REGULAÇÃO

Existem avanços na regulação das IAs acontecendo, agora, em vários países do mundo, incluindo o Brasil. Em 4 de maio, Rodrigo Pacheco, presidente do Senado Federal, apresentou uma proposta de regulamentação das IAs, a ser discutida e votada em breve. As regras sugerem: a proibição de empresas de explorar a vulnerabilidade de consumidores, como deficientes e idosos; proibição de tratamento de determinadas bases de dados, sobretudo do uso de dados pessoais sensíveis ou de impactos desproporcionais em razão de características pessoais como origem geográfica, raça, cor ou etnia, gênero, orientação sexual, classe socioeconômica, idade, deficiência, religião ou opiniões políticas; a proibição do governo de avaliar o comportamento de usuários em redes sociais para definir se as pessoas terão direito a políticas públicas; o direito dos usuários de serem informados sobre como as inteligências artificiais tomam decisões; a obrigação de empresas corrigir vieses discriminatórias em sistemas de inteligência artificial. O projeto prevê multa de até R$ 50 milhões para empresas que violarem as regras impostas, que pode chegar à suspensão das atividades.

Mas, na vanguarda, encontram-se, por motivos diversos, a União Europeia, com seu projeto de lei EU AI Act, que tem como preocupação principal o impedimento de interferência estatal e a eliminação de vieses preconceituosos, e a China, com o objetivo de manter o alinhamento com os valores socialistas do governo.

“A história nos mostra ondas sucessivas de inovação tecnológica, passando da experimentação para o crescimento rápido e, finalmente, para uma implementação mais segura e sustentável”, pondera em artigo Ellen Broad, professora adjunta da School of Cybernetics, na Australian National University. “Cada uma delas foi possibilitada pela difusão do conhecimento associado a essa tecnologia e pelo surgimento de novas profissões e novas especializações que contam com suas diversas formas.”

Ela lembra o exemplo da eletricidade, uma tecnologia que é frequentemente comparada à IA, tanto por seu potencial transformador quanto pela atenção que chamou, à sua época: “Em seu primeiro século, experimentos com eletricidade deram origem a novas ciências como a eletroterapia, posicionando as correntes elétricas como uma panacéia para uma série de doenças médicas. As pessoas lotaram as salas de aula para assistir a cientistas tentando reanimar os mortos. Livros médicos ofereciam conselhos sábios sobre a melhor forma de administrar choques elétricos em crianças. A eletricidade foi empregada como uma cura para a cegueira, tratamento para o câncer, bálsamo para uma ferida infectada e tônico para qualquer número de queixas sobriamente diagnosticadas como ‘histeria feminina’. Muitos desses tratamentos, inicialmente apresentados exaustivamente e aceitos acriticamente, acabariam sendo descartados como charlatanismo. Ao longo do caminho, os investidores perderam milhões, os pacientes ficaram sem dinheiro e pessoas foram feridas, mutiladas e mortas. Alguns desses tratamentos, com o benefício de pesquisa e avaliação, testes e padrões de segurança, passariam a fazer parte da medicina moderna. Eles assumiram novos nomes e formas. Na Austrália, acabariam por permitir a invenção do marcapasso elétrico e dos aparelhos auditivos.”

Ela chama a atenção para a generalização do termo IA “para substituir descrições mais escrupulosas, que tornariam transparentes e compreensíveis para as pessoas comuns as tecnologias às quais se referem”, como “mecanismos de busca, chatbots, filtros de spam, robôs, reconhecimento facial, assistentes digitais e algoritmos de recomendação – qualquer coisa (desde que seja nova) que automatiza tarefas usando software.”

Após 250 anos do surgimento da eletricidade, jamais pensaríamos em formar profissionais ou regular sob as mesmas leis eletrotécnicos (que sobem em postes), engenheiros eletrônicos (que projetam circuitos) ou bio-engenheiros (que prototipam dispositivos de eletroterapia), embora compartilhem a mesma tecnologia.

“A linguagem importa”, argumenta Broad. “Reunir uma série de tecnologias diferentes, feitas para propósitos e contextos diferentes, sob um termo, nos impede de articular nossas preocupações específicas e agir sobre as peças que mais importam no momento. A solução perfeita não será um simples livro de regras, abrangendo toda a nossa sociedade – será complexa, refletindo a sociedade que procura moldar. Será incremental, diversa e abraçará a complexidade. E terá como objetivo construir um sistema robusto, distribuído e multicamadas de regulamentação e expertise.”

Silvio Meira oferece à Continente o mesmo argumento, de maneira mais contundente: “Não acho que deveríamos regular agora o que não podemos entender ainda. Regular IA agora é como regular deuses: que deuses podem ‘existir’? Um deus-sol pode? Um de longas barbas brancas, que cria o universo, pode? A resposta é que, como todos são uma criação humana, todos os que criamos, podem, e são ‘naturais’, porque criação da natureza humana. Mas nem todos são sustentáveis. Seleção natural existe até para deuses. Ainda é muito cedo para regular a IA. Ainda não criamos nem o começo dessa história. Estamos escrevendo software há mais de 75 anos, e ainda não regulamos como o software deveria ser escrito e teria que funcionar. Tem algum ensinamento aí. A gente deveria refletir sobre isso. Enquanto ainda é tempo”.

Vivemos tempos interessantes, como diz o ditado apócrifo da maldição chinesa. Não temos tempo de temer a morte, mas é preciso estar atento e forte. Mais perigosos do que seus defeitos, talvez, seja a dependência que toda a sociedade terá das IAs. Como os nativos do filme, com a garrafa de coca-cola. Em breve, pode ser que ninguém mais saiba escrever parágrafos, ou pintar quadros, ou tocar instrumentos musicais. Que o potencial da IA sirva a propósitos mais nobres do que contribuir com nossa própria alienação.

Lula Pinto propõe um posicionamento diferente do cidadão, em relação às tecnologias: “Acho que há ainda uma outra fronteira de disputa, mais sutil e que também precisa ser acionada para limitar e estabelecer limites ao que de problemático as IAs oferecem. Me refiro à postura que adotamos em relação a esses objetos técnicos e a muitos outros. Somos levados a adotar a postura de clientes, de usuários dessas tecnologias. Penso que essa postura precisa ser repensada por nossa sociedade, nos ambientes de trabalho e educação. A postura de usuários, de clientes, nos fragiliza e nos coloca à mercê de empresas não confiáveis com a Google ou a OpenAI.”

A preocupação de Pinto ecoa a do pioneiro Marvin Minky, que nos deixou em 2016 (mas acredita-se que esteja congelado em algum lugar, esperando que o mundo evolua o bastante para conseguirmos ressuscitá-lo). Em uma breve entrevista à revista Wired, publicada em agosto de 2003, quando perguntado sobre os perigos da tecnologia, respondeu: “Acredito que precisamos assumir um papel positivo e ativo na determinação da direção em que as tecnologias seguirão, e não apenas ficar sentados na praia, servidos de martinis por máquinas”.

“Robôs que servem martinis na praia? Até que não seria mau,” disse o repórter Josh Mchugh. “Eu odeio ficar deitado na praia,” retrucou Minsky. “Pra mim, é pior do que uma prisão.”

YELLOW, programador, mestre em Ciências da Linguagem, designer e músico.

DAVI AUGUSTO, pós-graduado em Design Editorial pelo Istituto Europeo di Design e mestre em Design Digital pela PUC-SP. Colabora mensalmente com publicações como Financial Times (UK), The Telegraph (UK), L’Express (França), Wired (UK ) e Capital (Alemanha).